728x90

반응형

매개변수

- 매개변수는 주어진 데이터로부터 학습을 통해 모델 내부에서 결정되는 변수이다.

매개변수 최적화

- 학습 모델과 실제 레이블 차이는 손실 함수로 표현되며, 학습의 목적은 오차, 손실 함수의 값을 최대한 작게 하도록 하는 매개변수(가중치, 편향)를 찾는 것이다.

- 매개변수의 최적값을 찾는 문제이며, 이러한 문제를 푸는 것을 최적화라 한다.

- 가중치 : 각 입력값에 각기 다르게 곱해지는 수치

- 편향 : 하나의 뉴런에 입력된 모든 값을 다 더한 값에 더해주는 상수

매개변수 종류

- 가중치 : 각 입력값에 각기 다르게 곱해지는 수치

- 편향 : 하나의 뉴런에 입력된 모든 값을 다 더한 값에 더해주는 상수

매개변수 최적화 기법

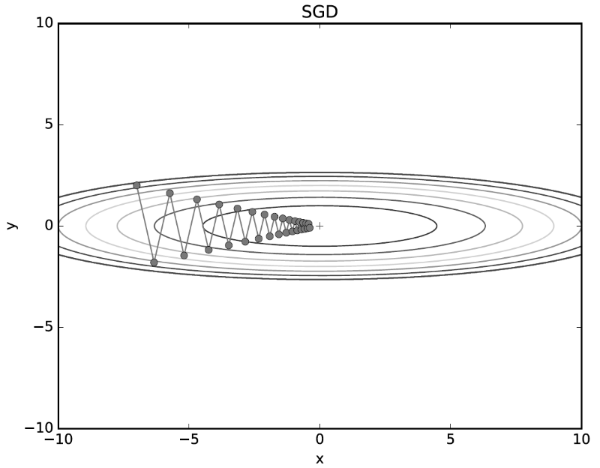

① 확률적 경사 하강법(SGD)

- 확률적 경사 하강법이란 손실 함수의 기울기를 구하여, 그 기울기를 따라 조금씩 아래로 내려가 최종적으로는 손실 함수가 가장 작은 지점에 도달하도록 하는 알고리즘이다.

- 기울기를 구하는데 학습 1회에 필요한 한 개의 데이터가 무작위로 선택이 되어 확률적이라고 한다.

- 손실 함수 그래프에서 지역 극소점에 갇혀 전역 극소점을 찾지 못하는 경우가 많고, 손실 함수가 비등방성 함수일 떄에서는 최적화에 있어 매우 비효율적이고 오래 걸리는 탐색 경로를 보여준다.

- 확률적 경사 하강법의 단점을 개선해 주는 기법으로 Momentum, AdaGrad, RMSProp, Adam이 있다.

⭐ 확률적 경사 하강법 특징

- 기울기가 줄어드는 최적점 근처에서 느리게 진행한다.

- 탐색 경로가 지그재그로 크게 변한다.

- 확률적 경사 하강법은 다음 그림과 같이 심하게 굽어져 지그재그의 움직임을 보여준다.

② Momentum(모멘텀)

- 모멘텀은 기울기 방향으로 힘을 받으면 물체가 가속된다는 물리 법칙을 적용한 알고리즘이다.

- 확률적 경사 하강법에 속도라는 개념을 적용한다.

- 기울기가 줄어들더라도 누적된 기울기 값으로 인해 빠르게 최적점으로 수렴할 수 있는 매개변수 최적화 기법이다.

⭐ 모멘텀의 특징

- 관성의 방향을 고려해 진동과 폭을 줄이는 효과가 있다.

- 탐색 경로의 변위가 줄어들어 빠르게 최적점으로 수렴한다.

- 확률적 경사 하강법과 비교하면 지그재그 정도가 덜하다.

- x의 한 방향으로 일정하게 가속하고, y축 방향의 속도는 일정하지 않다.

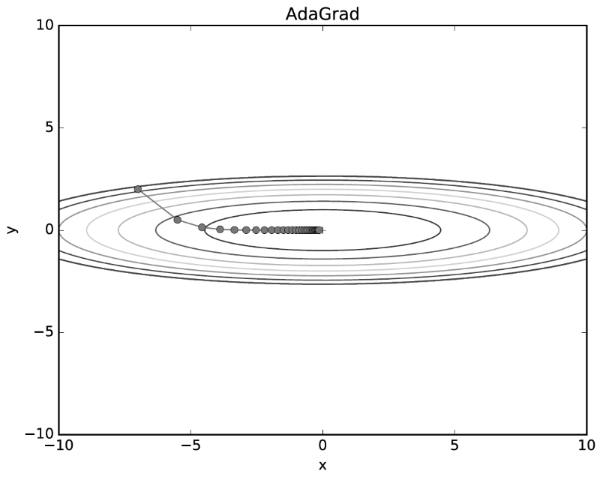

③ AdaGrad

- 손실 함수의 기울기가 큰 첫 부분에서는 크게 학습하다가, 최적점에 가까워질수록 학습률을 줄여 조금씩 적게 학습하는 방식이다.

- 학습을 진행하면서 학습률을 점차 줄여나가는 학습률 감소 기법을 적용한 최적화 알고리즘이다.

- 매개변수 전체의 학습률 값을 일과적으로 낮추는 것이 아니라 각각의 매개변수에 맞는 학습률값을 만들어주는 방식이다.

⭐AdaGrad의 특징

- AdaGrad 기법의 최적점 탐색 경로를 보면, 최적점을 향해 매우 효율적으로 움직이다.

- 처음에는 큰 폭으로 움직이지만, 그 큰 움직임에 비례하여 갱신 정도도 큰 폭으로 작아진다.

- 갱신 강도가 빠르게 약해지고, 지그재그 움직인이 눈에 띄게 줄어들어 빠르게 최적점으로 수렴한다.

- 최솟값을 향해 효율적으로 움직인다.

- y축 방향은 기울기가 커서 처음에는 크게 움직이지만, 큰 움직임에 비례해 갱신 정도도 큰 폭으로 작아지도록 조정된다.

- y축 방향으로 갱신 강도가 빠르게 약해지고, 지그재그 움직임이 줄어든다.

④ RMSProp

- RMSProp은 매개변수에 대해 학습률을 조정하는 방법이다.

- 가중치에 대한 학습률을 해당 가중치에 대한 최근 기울기 크기의 실행 평균으로 나눈다.

- AdaGrad가 복잡한 다차원 곡면함수를 잘 탐색할 수 없는 단점을 보완한 기법이다.

- 기울기를 단순 누적하지 않고 지수가중이동평균을 사용하여 최신 기울기들이 더 크게 반영된다.

⑤ Adam

- 모멘텀 방식과 AdaGrad방식의 장점을 합친 알고리즘이다.

- 최적점 탐색 경로 또한 이 두 방식을 합친 것과 비슷한 양상으로 나타난다.

⭐ Adam의 특징

- 탐색 경로의 전체적인 경향은 모멘텀 방식처럼 공이 굴러가는 듯하고, AdaGrad로 인해 갱신 강도가 조정되므로 모멘텀 방식보다 좌우 흔들림이 덜 한 것을 볼수 있다.

- Adam의 갱신 과정은 그릇 바닥을 구르듯 움직인다.

- 모멘텀과 비슷한 패턴이지만, 모멘텀보다 공의 좌우 흔들림이 적다.

매개변수 최적화 기출문제

Q. 다음 중 경사하강법이 아닌것은 무엇인가? [3회차]

① Adaboost

② rmsprop

③ adam

④ momentum

더보기

① Adaboost

728x90

반응형

'자격증 > 빅데이터분석기사' 카테고리의 다른 글

| [빅데이터분석기사 필기] 데이터 수집 개념 및 기출문제 (0) | 2022.09.29 |

|---|---|

| 빅데이터분석기사 필기 - 데이터 시각화 종류와 기출문제 (3) | 2022.09.29 |

| [빅데이터분석기사 필기] 과대 적합 개념 및 기출문제 (0) | 2022.09.29 |

| [빅데이터분석기사 필기] 회귀 모형의 평가지표 개념 및 기출문제 (1) | 2022.09.29 |

| [빅데이터분석기사 필기] 적합도 검정 개념 및 기출문제 (0) | 2022.09.29 |